Reconocimiento de gestos

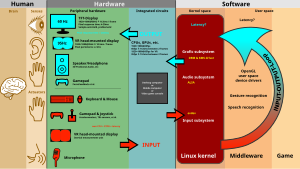

El reconocimiento de gestos forma parte de las ciencias de la computación y la tecnología del lenguaje y tiene como objetivo interpretar gestos humanos a través de algoritmos matemáticos. Los gestos pueden ser cualquier movimiento corporal o estado, pero comúnmente se originan a partir de la cara o la mano. Enfoques actuales en el campo incluyen reconocimiento de la emoción facial y el reconocimiento de gestos de la mano. Muchos enfoques que se han hecho hacen uso de cámaras y visión (por medio de cámaras) y se procesan por medio de algoritmos para interpretar el lengua de señas. Sin embargo, la identificación y el reconocimiento de la postura, la marcha, la proxémica, y los comportamientos humanos es también el tema de técnicas de reconocimiento de gestos.[1] El reconocimiento de gestos puede ser visto como una manera para que las computadoras empiecen a entender el lenguaje corporal humano, construyendo así una relación más sólida entre máquinas y seres humanos. Dejando atrás sistemas primitivos como las interfaces de usuario de texto o incluso GUIs (interfaces gráficas de usuario), que aún limitan la mayoría de las entradas informáticas al teclado y el ratón.

El reconocimiento de gestos permite a seres humanos comunicarse con la máquina (HMI) e interactuar naturalmente sin dispositivos mecánicos. Utilizando el concepto de reconocimiento de gestos, es posible usar los dedos en un espacio libre para relacionar movimientos del cursor con el movimiento del usuario. Esto podría hacer que los dispositivos convencionales de entrada, tales como ratón, teclados e incluso pantallas táctiles sean redundantes.

El Reconocimiento de gestos puede llevarse a cabo con técnicas de visión por medio de cámaras, webcams o dispositivos móviles y procesamiento de imágenes .

La siguiente literatura incluye trabajos en curso en el campo de la visión artificial en la captura de gestos o acciones más humanas en general y movimientos por cámaras conectadas a un ordenador.[2][3][4][5]

Esta tecnología no sólo va a reducir el impacto del hardware en el sistema, también aumentará el rango de usos aplicables desde un objeto en el mundo físico a un objeto en el mundo digital, como teclados, mouses, etc. El uso de esta tecnología que podemos implementar puede crear una nueva tesis de la creación de un nuevo hardware sin necesidad de monitores. Esta idea nos puede llevar a la creación de la pantalla holográfica. El plazo de reconocimiento de gestos se ha utilizado para referirse más estrechamente a los símbolos de escritura a mano, no son entradas de textos, como el entintado en una tableta gráfica, gestos multi-touch y movimientos de ratón. Ésta es la interacción del ordenador a través del dibujo de símbolos con un dispositivo cursor o señalador.[6][7][8]

Tipos de Gestos

[editar]En interfaces de ordenador, se distinguen dos tipos de gestos:[9] Consideramos gestos en línea, que también pueden ser consideradas como manipulaciones directas como escalar y rotar. Por el contrario, fuera los gestos en líneas, se procesan generalmente después de que la interacción está terminada; por ejemplo, se dibuja un círculo para activar un menú contextual.

- Gestos Offline: Son gestos procesados después de la interacción del usuario con el objeto. Un ejemplo es el gesto para activar un menú.

- Gestos Online: Son los gestos de manipulación directa. Se utilizan para escalar o rotar un objeto tangible.

Dispositivos de entrada

[editar]La capacidad de realizar un seguimiento de los movimientos de una persona y determinar qué gestos pueden ser realizando se pueden lograr a través de diversas herramientas. Aunque hay una gran cantidad de investigaciones realizadas en la imagen / vídeo basado en el reconocimiento de gestos, hay una variación dentro de las herramientas y entornos utilizados entre implementaciones.

Guantes cableados. Estos pueden proporcionar datos de entrada a la computadora sobre la posición y la rotación de las manos utilizando dispositivos de seguimiento magnético o inercial. Además, algunos guantes pueden detectar los dedos con un alto grado de precisión (5-10 grados), o incluso proporcionar retroalimentación háptica del usuario, lo cual se convierte en lo que es una simulación del sentido del tacto. El primer dispositivo de seguimiento de mano de tipo guante disponible en el mercado fue el Dataglove,[10] un dispositivo de tipo guante que puede detectar la posición de la mano, el movimiento y los dedos, por separado. Esto utiliza cables de fibra óptica que se ejecutan en la parte posterior de la mano. Pulsos de luz son creados y cuando se doblan los dedos, fugas de luz a través de pequeñas grietas y la pérdida se registra, da una aproximación de la actitud de la mano. Cámaras de profundidad consciente. El uso de cámaras especializadas, como la luz estructurada o cámaras de tiempo de vuelo, se puede generar un mapa de profundidad de lo que se ve a través de la cámara a una distancia corta, y utilizar estos datos para aproximarse a una representación en 3D de lo que se está viendo. Estos pueden ser eficaces para la detección de gestos con las manos, debido a sus capacidades de corto alcance.[11]

- Stereo Cámaras. El uso de dos cámaras cuyas relaciones se conocen entre sí, una representación 3D se puede aproximar por la salida de las cámaras. Para obtener las relaciones de la cámara, se puede utilizar una referencia de posicionamiento como una raya-Lexian o infrarrojos emisores.[12] En combinación con la medición de movimiento directo (6D-Vision) los gestos pueden ser detectados directamente.

Gestos basados en controlador. Estos controladores actúan como una extensión del cuerpo de modo que cuando se llevan a cabo gestos, algunos de su movimientos pueden ser capturados convenientemente mediante software. Los gestos del ratón son un ejemplo, donde el movimiento del ratón se correlaciona con un símbolo que está dibujado por una persona de mano, al igual que el mando de Wii o el Myo, que pueden estudiar los cambios en la aceleración en el tiempo para representar los gestos.[13][14][15] Los dispositivos, tales como la varita mágica de LG Electronics, el lazo y la primicia utilizar Hillcrest Laboratories ' tecnología Freespace, que utilizan acelerómetros MEMS, giroscopios y otros sensores para traducir los gestos en el movimiento del cursor. El software también compensa el temblor humano y el movimiento involuntario.[16][17][18] Los sensores inteligentes de estos cubos emisores de luz se pueden utilizar para detectar manos y dedos, así como otros objetos cercanos, y se pueden utilizar para procesar los datos. La mayoría de las aplicaciones son en la música y la síntesis de sonido,[19] pero pueden ser aplicados a otros campos.

- Single camera. Una cámara 2D estándar se puede utilizar para el reconocimiento de gestos donde los recursos / medio ambiente no serían convenientes para otras formas de reconocimiento basada en imágenes. Anteriormente se pensaba que una sola cámara puede no ser tan eficaz como estéreo o profundidad cámaras conscientes, pero algunas compañías están desafiando esta teoría. Tecnología de reconocimiento de gestos basada en software con una cámara 2D estándar que puede detectar gestos robustos de mano, señales con las manos, así como la pista manos o los dedos en una gran precisión ya se ha incrustado en ultrabooks Yoga de Lenovo [aclaración necesaria], teléfonos inteligentes de Pantech Vega LTE, Hisense de modelos de Televisión inteligente, entre otros dispositivos.

Algoritmos

[editar]Dependiendo del tipo de datos de entrada, el enfoque para interpretar un gesto podría hacerse de diferentes maneras. Sin embargo, la mayoría de las técnicas se basan en indicadores clave representados en un sistema de coordenadas 3D. Basado en el movimiento relativo de estos, el gesto puede ser detectado con una alta precisión, dependiendo de la calidad de la entrada y el enfoque del algoritmo.

Con el fin de interpretar los movimientos del cuerpo, uno tiene que clasificarlos de acuerdo a las propiedades comunes y el mensaje de los movimientos que pueden expresar. Por ejemplo, en lengua de signos cada gesto representa una palabra o frase. La taxonomía, que parece muy apropiada para la Interacción Persona-Ordenador, ha sido propuesto por Quek en "Hacia una interfaz de gesto de mano Vision-Based".[20] Se presentan varios sistemas de gestos interactivos con el fin de capturar todo el espacio de los gestos: 1. Manipulador; 2. Semafórico; 3. Conversacional.

Existen dos enfoques diferentes en el reconocimiento de gestos:. Un modelo basado en 3D y una por la apariencia[21] El método más importante hace uso de la información 3D de los elementos clave de las partes del cuerpo con el fin de obtener varios parámetros importantes, como la posición de palma o ángulos de las articulaciones. Por otro lado, los sistemas basados en apariencia utilizan imágenes o vídeos para la interpretación directa.

Algoritmos basados en modelos 3D

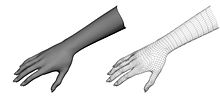

[editar]El enfoque de los modelos en 3D se puede utilizar para la creación de modelos volumétricos o esqueléticos, o incluso una combinación de los dos. Se han usado planteamientos volumétricos en gran medida en la industria de la animación por computadoras con fines de visión digital. Los modelos se crean generalmente con superficies 3D complicadas, como NURBS o mallas poligonales.

Este método es inconveniente ya que es de alta demanda computacional y los sistemas de análisis en vivo todavía se están desarrollando. Por el momento, un enfoque más interesante sería asignar objetos primitivos simples a más importantes partes del cuerpo de la persona (por ejemplo, cilindros de los brazos y el cuello, esfera para la cabeza) y analizar la forma en que éstos interactúan entre sí. Además, algunas estructuras abstractas como super-cuádricas y cilindros generalizados pueden ser aún más conveniente para la aproximación de las partes del cuerpo. Lo emocionante de este enfoque es que los parámetros para estos objetos son muy simples. Con el fin de modelar mejor la relación entre ellos, hacemos uso de las limitaciones y las jerarquías entre los objetos.

La versión esquelética (a la derecha) está modelando efectivamente la mano (izquierda). Esto tiene un menor número de parámetros que la versión volumétrica y es más fácil de calcular, por lo que es adecuado para sistemas de análisis de gesto en tiempo real.

Algoritmos basados esqueletos

[editar]En lugar de utilizar el procesamiento intensivo de los modelos 3D y hacer frente a una gran cantidad de parámetros, uno puede usar una versión simplificada de los parámetros de ángulo de la articulación junto con longitudes de segmento. Esto se conoce como una representación del esqueleto del cuerpo, donde se calcula un esqueleto virtual de la persona y las partes del cuerpo se asignan a determinados segmentos. El análisis se hace usando la posición y orientación de estos segmentos y la relación entre cada uno de ellos (por ejemplo, el ángulo entre las articulaciones y la posición relativa o la orientación).

Ventajas del uso de modelos esqueléticos:

- Los algoritmos son más rápidos porque sólo se analizan los parámetros clave.

- Es posible la coincidencia de patrones en contra de una base de datos de plantilla.

- El uso de los puntos clave permite que el programa de detección para centrarse en las partes importantes del cuerpo

Modelos basados en la apariencia

[editar]Estos modelos no utilizan una representación espacial del cuerpo, porque se derivan los parámetros directamente de las imágenes o vídeos con una base en los datos de la plantilla. Algunos se basan en las plantillas 2D deformables de las partes del cuerpo humano, en particular de las manos. Las plantillas deformables son un conjunto de puntos en el contorno de un objeto, que se utilizan como nodos de interpolación para el contorno de aproximación del objeto. La función de interpolación más simple es lineal. La cual realiza una forma promedio del conjunto de puntos, y parámetros de deformación variable externos. Estos modelos basados en plantillas se utilizan sobre todo para la mano de seguimiento, pero también podrían ser de utilidad para la clasificación simple de gestos.

Un segundo enfoque en gesto de detectar el uso de modelos basados en apariencia utiliza secuencias de imágenes como plantillas gesto. Los parámetros para este método son o bien los propios, o ciertas características de las imágenes derivadas de estos. La mayoría del tiempo, sólo uno (monoscópico) o dos utilizan vistas estereoscópicas.

Retos

[editar]Hay muchos retos asociados con la precisión y utilidad del software de reconocimiento de gestos. Debido a que está basado en imágenes de gestos hay limitaciones en el equipo utilizado y en el ruido de las imágenes. Las imágenes o vídeos pueden no estar en condiciones de iluminación constante, o en el mismo lugar. Los antecedentes o rasgos distintivos de los usuarios pueden hacer más difícil el reconocimiento.

La variedad de implementaciones de la imagen basada en el reconocimiento de gestos también puede causar un problema para la viabilidad de la tecnología en el uso general. Por ejemplo, un algoritmo de calibrado para una cámara puede no funcionar para otra cámara. La cantidad de ruido de fondo también puede ser causa de seguimiento y de reconocimiento de dificultades, especialmente cuando se producen oclusiones (parciales y completas). Además, la distancia desde la cámara, la resolución y la calidad de la misma también causan variaciones en la precisión del reconocimiento.

Con el fin de captar los gestos humanos por sensores visuales, también se requieren métodos de visión robusta en computación, por ejemplo, para el seguimiento de la mano y el reconocimiento postura de la mano[22][23][24][25][26][27][28][29][30] o para la captura de movimientos de la cabeza, expresiones faciales o dirección de la mirada.

"Gorilla arm"

[editar]"Gorilla arm" era un efecto secundario de la pantalla táctil orientado verticalmente o con uso de la luz-pen. En periodos de uso prolongado, los brazos de los usuarios comenzaron a sentir fatiga y / o incomodidad. Este efecto sumado a la disminución de la entrada de pantalla táctil y pesaron en su popularidad inicial en la década de 1980.[31][32]

Con el fin de medir la fatiga del brazo y el efecto secundario brazo gorila, los investigadores desarrollaron una técnica llamada Consumer Endurance (Persistencia del consumidor).[33]

WiSee

[editar]WiSee es una interfaz de interacción que potencia las transmisiones inalámbricas en curso en el ambiente (p.ej., WiFi) para posibilitar la percepción y reconocimiento en toda la casa de los gestos humanos.[34][35]

Referencias

[editar]- ↑ Matthias Rehm, Nikolaus Bee, Elisabeth André, Wave Like an Egyptian - Accelerometer Based Gesture Recognition for Culture Specific Interactions, British Computer Society, 2007

- ↑ Pavlovic, V., Sharma, R. & Huang, T. (1997), "Visual interpretation of hand gestures for human-computer interaction: A review", IEEE Trans. Pattern Analysis and Machine Intelligence., July, 1997. Vol. 19(7), pp. 677 -695.

- ↑ R. Cipolla and A. Pentland, Computer Vision for Human-Machine Interaction, Cambridge University Press, 1998, ISBN 978-0-521-62253-0

- ↑ Ying Wu and Thomas S. Huang, "Vision-Based Gesture Recognition: A Review", In: Gesture-Based Communication in Human-Computer Interaction, Volume 1739 of Springer Lecture Notes in Computer Science, pages 103-115, 1999, ISBN 978-3-540-66935-7, doi 10.1007/3-540-46616-9

- ↑ Alejandro Jaimesa and Nicu Sebe, Multimodal human–computer interaction: A survey, Computer Vision and Image Understanding Volume 108, Issues 1-2, October–November 2007, Pages 116-134 Special Issue on Vision for Human-Computer Interaction, doi 10.1016/j.cviu.2006.10.019

- ↑ Dopertchouk, Oleg; "Recognition of Handwriting Gestures", gamedev.net, January 9, 2004

- ↑ Chen, Shijie; "Gesture Recognition Techniques in Handwriting Recognition Application", Frontiers in Handwriting Recognition p 142-147 November 2010

- ↑ Balaji, R; Deepu, V; Madhvanath, Sriganesh; Prabhakaran, Jayasree "Handwritten Gesture Recognition for Gesture Keyboard", Hewlett-Packard Laboratories

- ↑ Dietrich Kammer, Mandy Keck, Georg Freitag, Markus Wacker, Taxonomy and Overview of Multi-touch Frameworks: Architecture, Scope and Features Archivado el 25 de enero de 2011 en Wayback Machine.

- ↑ Thomas G. Zimmerman, Jaron Lanier, Chuck Blanchard, Steve Bryson and Young Harvill. http://portal.acm.org. "A HAND GESTURE INTERFACE DEVICE." http://portal.acm.org.

- ↑ Yang Liu, Yunde Jia, A Robust Hand Tracking and Gesture Recognition Method for Wearable Visual Interfaces and Its Applications, Proceedings of the Third International Conference on Image and Graphics (ICIG’04), 2004

- ↑ Kue-Bum Lee, Jung-Hyun Kim, Kwang-Seok Hong, An Implementation of Multi-Modal Game Interface Based on PDAs, Fifth International Conference on Software Engineering Research, Management and Applications, 2007

- ↑ Per Malmestig, Sofie Sundberg, SignWiiver - implementation of sign language technology

- ↑ Thomas Schlomer, Benjamin Poppinga, Niels Henze, Susanne Boll, Gesture Recognition with a Wii Controller Archivado el 27 de julio de 2013 en Wayback Machine., Proceedings of the 2nd international Conference on Tangible and Embedded interaction, 2008

- ↑ AiLive Inc., LiveMove White Paper, 2006

- ↑ Electronic Design September 8, 2011. William Wong. Natural User Interface Employs Sensor Integration.

- ↑ Cable & Satellite International September/October, 2011. Stephen Cousins. A view to a thrill. Archivado el 19 de enero de 2012 en Wayback Machine.

- ↑ TechJournal South January 7, 2008. Hillcrest Labs rings up $25M D round.

- ↑ Percussa AudioCubes Blog October 4, 2012. Gestural Control in Sound Synthesis. Archivado el 10 de septiembre de 2015 en Wayback Machine.

- ↑ Quek, F., "Toward a vision-based hand gesture interface" Proceedings of the Virtual Reality System Technology Conference, pp. 17-29, August 23–26, 1994, Singapore

- ↑ Vladimir I. Pavlovic, Rajeev Sharma, Thomas S. Huang, Visual Interpretation of Hand Gestures for Human-Computer Interaction; A Review, IEEE Transactions on Pattern Analysis and Machine Intelligence, 1997

- ↑ Ivan Laptev and Tony Lindeberg "Tracking of Multi-state Hand Models Using Particle Filtering and a Hierarchy of Multi-scale Image Features", Proceedings Scale-Space and Morphology in Computer Vision, Volume 2106 of Springer Lecture Notes in Computer Science, pages 63-74, Vancouver, BC, 1999. ISBN 978-3-540-42317-1, doi 10.1007/3-540-47778-0

- ↑ von Hardenberg, Christian; Bérard, François (2001). «Bare-hand human-computer interaction». Proceedings of the 2001 workshop on Perceptive user interfaces. ACM International Conference Proceeding Series. 15 archive. Orlando, Florida. pp. 1-8.

- ↑ Lars Bretzner, Ivan Laptev, Tony Lindeberg "Hand gesture recognition using multi-scale colour features, hierarchical models and particle filtering", Proceedings of the Fifth IEEE International Conference on Automatic Face and Gesture Recognition, Washington, DC, USA, 21–21 May 2002, pages 423-428. ISBN 0-7695-1602-5, doi 10.1109/AFGR.2002.1004190

- ↑ Domitilla Del Vecchio, Richard M. Murray Pietro Perona, "Decomposition of human motion into dynamics-based primitives with application to drawing tasks", Automatica Volume 39, Issue 12, December 2003, Pages 2085-2098 , doi 10.1016/S0005-1098(03)00250-4.

- ↑ Thomas B. Moeslund and Lau Nørgaard, "A Brief Overview of Hand Gestures used in Wearable Human Computer Interfaces", Technical report: CVMT 03-02, ISSN 1601-3646, Laboratory of Computer Vision and Media Technology, Aalborg University, Denmark.

- ↑ M. Kolsch and M. Turk "Fast 2D Hand Tracking with Flocks of Features and Multi-Cue Integration", CVPRW '04. Proceedings Computer Vision and Pattern Recognition Workshop, May 27-June 2, 2004, doi 10.1109/CVPR.2004.71

- ↑ Xia Liu Fujimura, K., "Hand gesture recognition using depth data", Proceedings of the Sixth IEEE International Conference on Automatic Face and Gesture Recognition, May 17–19, 2004 pages 529- 534, ISBN 0-7695-2122-3, doi 10.1109/AFGR.2004.1301587.

- ↑ Stenger B, Thayananthan A, Torr PH, Cipolla R: "Model-based hand tracking using a hierarchical Bayesian filter", IEEE Transactions on Pattern Analysis and Machine Intelligence, 28(9):1372-84, Sep 2006.

- ↑ A Erol, G Bebis, M Nicolescu, RD Boyle, X Twombly, "Vision-based hand pose estimation: A review", Computer Vision and Image Understanding Volume 108, Issues 1-2, October–November 2007, Pages 52-73 Special Issue on Vision for Human-Computer Interaction, doi 10.1016/j.cviu.2006.10.012.

- ↑ Windows 7? No arm in it - Mixed Signals - Rupert Goodwins's Blog at ZDNet.co.uk Community

- ↑ The Jargon File - Gorilla Arm

- ↑ Consumed endurance: a metric to quantify arm fatigue of mid-air interactions

- ↑ http://wisee.cs.washington.edu/

- ↑ http://www.smartplanet.com/blog/bulletin/wisee-gesture-recognition-in-your-entire-home/21171

Enlaces externos

[editar]- Annotated bibliography of references to gesture and pen computing

- Notes on the History of Pen-based Computing (YouTube)

- The future, it is all a Gesture—Gesture interfaces and video gaming

- Ford's Gesturally Interactive Advert—Gestures used to interact with digital signage

- Kinetic Space—3D Gesture Recognition, Training & Analysis

- Look Ma No Trackpad—Gestures used to control Spotify & iTunes

- The Gesture Recognition Toolkit Archivado el 28 de abril de 2014 en Wayback Machine.—An open-source toolkit for gesture recognition